搜狗已为您找到约11,841条相关结果

在线robots.txt文件生成工具 - UU在线工具

什么是 Robots.txt?如何设置?网站优化必看指南与注意事项_搜索引擎...

【python爬虫】robotstxt文件说明,robots.txt:如何让搜索引擎不要抓...

robots.txt - Blog - SegmentFault 思否

robots.txt怎么设置-CSDN博客

- 来自:百变鹏仔

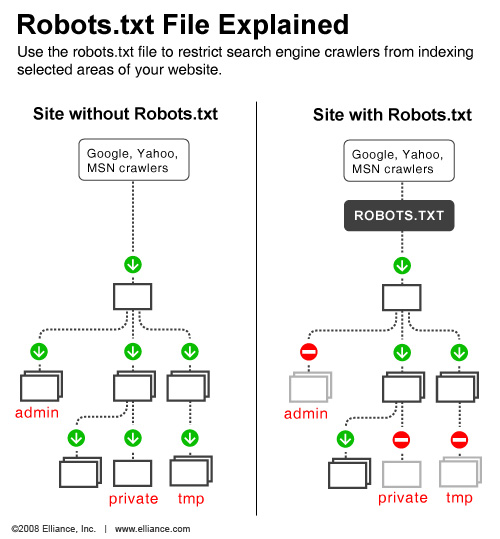

- robots.txt 文件只适用于公共可见的部分,而不适用于需要登录或其他限制访问的部分.如果你需要更精确地控制机器人的访问,可能需要使用其他技术,如密码保护、IP 地址限制...

robots.txt存放的位置robots.txt文件的作用及写法 (搜索引擎)-CSDN...

- 来自:叶涛网站推广优化

- robots.txt语法:</p> <p>1)User-agent 定义搜索引擎.一般情况下,网站里面都是:User-agent: *,这里*的意思是所有,表示定义所有的搜索引擎.比如,我想定义百度,那么就...

robots.txt网站爬虫文件设置_weixin_33766805的博客-CSDN博客

- 来自:weixin_33766805

- robots.txt使用误区</li> <li style='background-image:url("http://common.cnblogs.com/Skins/Minyx2_Lite/images/icon_miniarrow.gif");background-position:0px 9px;'>robots.txt使用技...

Google开源robots.txt解析器

Google开源robots.txt解析器